Меры информации (синтаксическая, семантическая, прагматическая). Меры информации семантического уровня

Тема 2. Основы представления и обработки информации в компьютере

Литература

1. Информатика в экономике: Учебное пособие/Под ред. Б.Е. Одинцова, А.Н. Романова. – М.: Вузовский учебник, 2008.

2. Информатика: Базовый курс: Учебное пособие/Под ред. С.В. Симоновича. – СПб.: Питер, 2009.

3. Информатика. Общий курс: Учебник/Соавт.: А.Н. Гуда, М.А. Бутакова, Н.М. Нечитайло, А.В. Чернов; Под общ. ред. В.И. Колесникова. – М.: Дашков и К, 2009.

4. Информатика для экономистов: Учебник/Под ред. Матюшка В.М. - М.: Инфра-М, 2006.

5. Экономическая информатика: Введение в экономический анализ информационных систем.- М.: ИНФРА-М, 2005.

Меры информации (синтаксическая, семантическая, прагматическая)

Для измерения информации могут применяться различные подходы, но наибольшее распространение получили статистический (вероятностный), семантический и прагматический методы.

Статистический (вероятностный) метод измерения информации был разработан К. Шенноном в 1948 году, который предложил количество информации рассматривать как меру неопределенности состояния системы, снимаемой в результате получения информации. Количественно выраженная неопределенность получила название энтропии. Если после получения некоторого сообщения наблюдатель приобрел дополнительную информацию о системе Х, то неопределенность уменьшилась. Дополнительно полученное количество информации определяется как:

где - дополнительное количество информации о системе Х , поступившее в форме сообщения;

Начальная неопределенность (энтропия) системы X ;

Конечная неопределенность (энтропия) системы X, наступившая после получения сообщения.

Если система X может находиться в одном из дискретных состояний, количество которых n , а вероятность нахождения системы в каждом из них равна и сумма вероятностей всех состояний равна единице, то энтропия вычисляется по формуле Шеннона:

где - энтропия системы Х;

а - основание логарифма, определяющее единицу измерения информации;

n – количество состояний (значений), в котором может находится система.

Энтропия величина положительная, а так как вероятности всегда меньше единицы, а их логарифм отрицательный, поэтому знак минус в формуле К.Шеннона делает энтропию положительной. Таким образом, за меру количества информации принимается та же энтропия, но с обратным знаком.

Взаимосвязь информации и энтропии можно понимать следующим образом: получение информации (ее увеличение) одновременно означает уменьшение незнания или информационной неопределенности (энтропии)

Таким образом, статистический подход учитывает вероятность появления сообщений: более информативным считается то сообщение, которое менее вероятно, т.е. менее всего ожидалось. Количество информации достигает максимального значения, если события равновероятны.

Р. Хартли предложил следующую формулу для измерения информации:

I=log2n ,

где n - количество равновероятных событий;

I – мера информации в сообщении о наступлении одного из n событий

Измерение информации выражается в ее объёме. Чаще всего это касается объёма компьютерной памяти и объёма данных, передаваемых по каналам связи. За единицу принято такое количество информации, при котором неопределённость уменьшается в два раза, такая единица информации получила название бит .

Если в качестве основания логарифма в формуле Хартли используется натуральный логарифм (), то единицей измерения информации является нат (1 бит = ln2 ≈ 0,693 нат). Если в качестве основания логарифма используется число 3, то - трит , если 10, то - дит (хартли).

На практике чаще применяется более крупная единица - байт (byte ), равный восьми битам. Такая единица выбрана потому, что с ее помощью можно закодировать любой из 256 символов алфавита клавиатуры компьютера (256=28).

Кроме байтов информация измеряется полусловами (2 байта), словами (4 байта) и двойными словами (8 байт). Широко используются также еще более крупные единицы измерения информации:

1 Килобайт (Кбайт - kilobyte ) = 1024 байт = 210 байт,

1 Мегабайт (Мбайт - megabyte ) = 1024 Кбайт = 220 байт,

1 Гигабайт (Гбайт - gigabyte ) = 1024 Мбайт = 230 байт.

1 Терабайт (Тбайт - terabyte ) = 1024 Гбайт = 240 байт,

1 Петабайт (Пбайт - petabyte ) = 1024 Тбайт = 250 байт.

В 1980 году российский математик Ю. Манин предложил идею построения квантового компьютера, в связи с чем появилась такая единица информации как кубит (quantum bit, qubit) – «квантовый бит» – мера измерения объема памяти в теоретически возможном виде компьютера, использующем квантовые носители, например - спины электронов. Кубит может принимать не два различных значения («0» и «1»), а несколько, соответствующих нормированным комбинациям двух основных состояний спина, что дает большее число возможных сочетаний. Так, 32 кубита могут закодировать около 4 млрд состояний.

Семантический подход. Синтаксической меры не достаточно, если требуется определить не объем данных, а количество нужной в сообщении информации. В этом случае рассматривается семантический аспект, позволяющий определить содержательную сторону сведений.

Для измерения смыслового содержания информации можно воспользоваться тезаурусом ее получателя (потребителя). Идея тезаурусного метода была предложена Н. Винером и развита нашим отечественным ученым А.Ю. Шрейдером.

Тезаурусом называется совокупность сведений , которыми располагает получатель информации. Соотнесение тезауруса с содержанием поступившего сообщения позволяет выяснить, насколько оно снижает неопределенность..

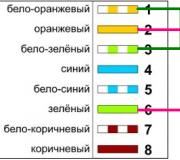

Зависимость объема смысловой информации сообщения от тезауруса получателя

Согласно зависимости, представленной на графике, при отсутствии у пользователя какого-либо тезауруса (знаний о существе поступившего сообщении, то есть =0), или наличия такого тезауруса, который не изменился в результате поступления сообщения (), то объем семантической информации в нем равен нулю. Оптимальным будет такой тезаурус (), при котором объем семантической информации будет максимальным (). Например, семантической информации в поступившем сообщении на незнакомом иностранном языке будет ноль , но и такая же ситуация будет в том случае, если сообщение уже не является новостью, так как пользователю уже все известно.

Прагматическая мера информации определяет ее полезность в достижении потребителем своих целей. Для этого достаточно определить вероятность достижения цели до, и после получения сообщения и сравнить их. Ценность информации (по А.А. Харкевичу) рассчитывается по формуле:

где - вероятность достижения цели до получения сообщения;

Вероятность достижения цели поле получения сообщения;

УРОВНИ ПРОБЛЕМ ПЕРЕДАЧИ ИНФОРМАЦИИ

При реализации информационных процессов всегда происходит перенос информации в пространстве и времени от источника информации к приемнику (получателю). При этом для передачи информации используют различные знаки или символы, например естественного или искусственного (формального) языка, позволяющие выразить ее в некоторой форме, называемой сообщением.

Сообщение - форма представления информации в виде совокупности знаков (символов), используемая для передачи.

Сообщение как совокупность знаков с точки зрения семиотики (от греч. semeion - знак, признак) - науки, занимающейся исследованием свойств знаков и знаковых систем, - может изучаться на трех уровнях :

1) синтаксическом, где рассматриваются внутренние свойства сообщений, т. е. отношения между знаками, отражающие структуру данной знаковой системы. Внешние свойства изучают на семантическом и прагматическом уровнях;

2) семантическом, где анализируются отношения между знаками и обозначаемыми ими предметами, действиями, качествами, т. е. смысловое содержание сообщения, его отношение к источнику информации;

3) прагматическом, где рассматриваются отношения между сообщением и получателем, т. е. потребительское содержание сообщения, его отношение к получателю.

Таким образом, учитывая определенную взаимосвязь проблем передачи информации с уровнями изучения знаковых систем, их разделяют на три уровня: синтаксический, семантический и прагматический.

Проблемы синтаксического уровня касаются создания теоретических основ построения информационных систем, основные показатели функционирования которых были бы близки к предельно возможным, а также совершенствования существующих систем с целью повышения эффективности их использования. Это чисто технические проблемы совершенствования методов передачи сообщений и их материальных носителей - сигналов. На этом уровне рассматривают проблемы доставки получателю сообщений как совокупности знаков, учитывая при этом тип носителя и способ представления информации, скорость передачи и обработки, размеры кодов представления информации, надежность и точность преобразования этих кодов и т. п., полностью абстрагируясь от смыслового содержания сообщений и их целевого предназначения. На этом уровне информацию, рассматриваемую только с синтаксических позиций, обычно называют данными, так как смысловая сторона при этом не имеет значения.

Современная теория информации исследует в основном проблемы именно этого уровня. Она опирается на понятие «количество информации», являющееся мерой частоты употребления знаков, которая никак не отражает ни смысла, ни важности передаваемых сообщений. В связи с этим иногда говорят, что современная теория информации находится на синтаксическом уровне.

Проблемы семантического уровня связаны с формализацией и учетом смысла передаваемой информации, определения степени соответствия образа объекта и самого объекта. На данном уровне анализируются те сведения, которые отражает информация, рассматриваются смысловые связи, формируются понятия и представления, выявляется смысл, содержание информации, осуществляется ее обобщение.

Проблемы этого уровня чрезвычайно сложны, так как смысловое содержание информации больше зависит от получателя, чем от семантики сообщения, представленного на каком-либо языке.

На прагматическом уровне интересуют последствия от получения и использования данной информации потребителем. Проблемы этого уровня связаны с определением ценности и полезности использования информации при выработке потребителем решения для достижения своей цели. Основная сложность здесь состоит в том, что ценность, полезность информации может быть совершенно различной для различных получателей и, кроме того, она зависит от ряда факторов, таких, например, как своевременность ее доставки и использования. Высокие требования в отношении скорости доставки информации часто диктуются тем, что управляющие воздействия должны осуществляться в реальном масштабе времени, т. е. со скоростью изменения состояния управляемых объектов или процессов. Задержки в доставке или использовании информации могут иметь катастрофические последствия.

Тема 2. Основы представления и обработки информации в компьютере

Литература

1. Информатика в экономике: Учебное пособие/Под ред. Б.Е. Одинцова, А.Н. Романова. – М.: Вузовский учебник, 2008.

2. Информатика: Базовый курс: Учебное пособие/Под ред. С.В. Симоновича. – СПб.: Питер, 2009.

3. Информатика. Общий курс: Учебник/Соавт.:А.Н. Гуда, М.А. Бутакова, Н.М. Нечитайло, А.В. Чернов; Под общ. ред. В.И. Колесникова. – М.: Дашков и К, 2009.

4. Информатика для экономистов: Учебник/Под ред. Матюшка В.М. - М.: Инфра-М, 2006.

5. Экономическая информатика: Введение в экономический анализ информационных систем.- М.: ИНФРА-М, 2005.

Меры информации (синтаксическая, семантическая, прагматическая)

Для измерения информации могут применяться различные подходы, но наибольшее распространение получили статистический (вероятностный), семантический и прагматический методы.

Статистический (вероятностный) метод измерения информации был разработан К. Шенноном в 1948 году, который предложил количество информации рассматривать как меру неопределенности состояния системы, снимаемой в результате получения информации. Количественно выраженная неопределенность получила название энтропии. Если после получения некоторого сообщения наблюдатель приобрел дополнительную информацию о системе Х, то неопределенность уменьшилась. Дополнительно полученное количество информации определяется как:

где - дополнительное количество информации о системе Х , поступившее в форме сообщения;

Начальная неопределенность (энтропия) системы X ;

Конечная неопределенность (энтропия) системы X, наступившая после получения сообщения.

Если система X может находиться в одном из дискретных состояний, количество которых n , а вероятность нахождения системы в каждом из них равна и сумма вероятностей всех состояний равна единице , то энтропия вычисляется по формуле Шеннона:

где - энтропия системы Х;

а - основание логарифма, определяющее единицу измерения информации;

n – количество состояний (значений), в котором может находится система.

Энтропия величина положительная, а так как вероятности всегда меньше единицы, а их логарифм отрицательный, поэтому знак минус в формуле К.Шеннона делает энтропию положительной. Таким образом, за меру количества информации принимается та же энтропия, но с обратным знаком.

Взаимосвязь информации и энтропии можно понимать следующим образом: получение информации (ее увеличение) одновременно означает уменьшение незнания или информационной неопределенности (энтропии)

Таким образом, статистический подход учитывает вероятность появления сообщений: более информативным считается то сообщение, которое менее вероятно, т.е. менее всего ожидалось. Количество информации достигает максимального значения, если события равновероятны.

Р. Хартли предложил следующую формулу для измерения информации:

I=log 2 n ,

где n - количество равновероятных событий;

I – мера информации в сообщении о наступлении одного из n событий

Измерение информации выражается в ее объёме. Чаще всего это касается объёма компьютерной памяти и объёма данных, передаваемых по каналам связи. За единицу принято такое количество информации, при котором неопределённость уменьшается в два раза, такая единица информации получила название бит .

Если в качестве основания логарифма в формуле Хартли используется натуральный логарифм (), то единицей измерения информации является нат (1 бит = ln2 ≈ 0,693 нат). Если в качестве основания логарифма используется число 3, то - трит , если 10, то - дит (хартли).

На практике чаще применяется более крупная единица - байт (byte ), равный восьми битам. Такая единица выбрана потому, что с ее помощью можно закодировать любой из 256 символов алфавита клавиатуры компьютера (256=2 8).

Кроме байтов информация измеряется полусловами (2 байта), словами (4 байта) и двойными словами (8 байт). Широко используются также еще более крупные единицы измерения информации:

1 Килобайт (Кбайт - kilobyte ) = 1024 байт = 2 10 байт,

1 Мегабайт (Мбайт - megabyte ) = 1024 Кбайт = 2 20 байт,

1 Гигабайт (Гбайт - gigabyte ) = 1024 Мбайт = 2 30 байт.

1 Терабайт (Тбайт - terabyte ) = 1024 Гбайт = 2 40 байт,

1 Петабайт (Пбайт - petabyte ) = 1024 Тбайт = 2 50 байт.

В 1980 году российский математик Ю. Манин предложил идею построения квантового компьютера, в связи с чем появилась такая единица информации как кубит (quantum bit, qubit) – «квантовый бит» – мера измерения объема памяти в теоретически возможном виде компьютера, использующем квантовые носители, например - спины электронов. Кубит может принимать не два различных значения ("0" и "1"), а несколько, соответствующих нормированным комбинациям двух основных состояний спина, что дает большее число возможных сочетаний. Так, 32 кубита могут закодировать около 4 млрд состояний.

Семантический подход. Синтаксической меры не достаточно, если требуется определить не объем данных, а количество нужной в сообщении информации. В этом случае рассматривается семантический аспект, позволяющий определить содержательную сторону сведений.

Для измерения смыслового содержания информации можно воспользоваться тезаурусом ее получателя (потребителя). Идея тезаурусного метода была предложена Н. Винером и развита нашим отечественным ученым А.Ю. Шрейдером.

Тезаурусом называется совокупность сведений , которыми располагает получатель информации. Соотнесение тезауруса с содержанием поступившего сообщения позволяет выяснить, насколько оно снижает неопределенность..

Зависимость объема смысловой информации сообщения от тезауруса получателя

Согласно зависимости, представленной на графике, при отсутствии у пользователя какого-либо тезауруса (знаний о существе поступившего сообщении, то есть =0), или наличия такого тезауруса, который не изменился в результате поступления сообщения (), то объем семантической информации в нем равен нулю. Оптимальным будет такой тезаурус (), при котором объем семантической информации будет максимальным (). Например, семантической информации в поступившем сообщении на незнакомом иностранном языке будет ноль , но и такая же ситуация будет в том случае, если сообщение уже не является новостью, так как пользователю уже все известно.

Прагматическая мера информации определяет ее полезность в достижении потребителем своих целей. Для этого достаточно определить вероятность достижения цели до, и после получения сообщения и сравнить их. Ценность информации (по А.А. Харкевичу) рассчитывается по формуле:

где - вероятность достижения цели до получения сообщения;

Вероятность достижения цели поле получения сообщения;

Классификация мер

Меры информации

Формы адекватности информации

Адекватность информации может выражаться в трех формах: семантической, синтаксической, прагматической.

Синтаксическая адекватность. Она отображает формально-структурные характеристики информации и не затрагивает ее смыслового содержания. На синтаксическом уровне учитываются тип носителя и способ представления информации, скорость передачи и обработки, размеры кодов её представления, надежность и точность преобразования этих кодов и т. п. Информацию, рассматриваемую только с синтаксических позиций, обычно называют данными, т.к. при этом не имеет значения смысловая сторона.

Семантическая (смысловая) адекватность. Эта форма определяет степень соответствия образа объекта и самого объекта. Семантический аспект предполагает учет смыслового содержания информации. На этом уровне анализируются те сведения, которые отражает информация, рассматриваются смысловые связи. В информатике устанавливаются смысловые связи между кодами представления информации. Эта форма служит для формирования понятий и представлений, выявления смысла, содержания информации и ее обобщения.

Прагматическая (потребительская) адекватность отражает отношение информации и ее потребителя, соответствие информации цели управления, которая на ее основе реализуется. Прагматические свойства информации проявляются только при наличии единства информации (объекта), пользователя и цели управления. Прагматический аспект рассмотрения связан с ценностью, полезностью использования информации при выработке потребителем решения для достижения своей цели.

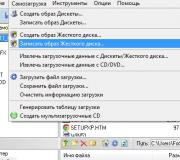

Для измерения информации вводятся два параметра: количество информации I и объем данных V. Эти параметры имеют разные выражения и интерпретацию в зависимости от рассматриваемой формы адекватности. Каждой форме адекватности соответствует своя мера количества информации и объема данных (рис. 2.1).

Объем данных V д в сообщении измеряется количеством символов (разрядов) в этом сообщении. В различных системах счисления один разряд имеет различный вес и соответственно меняется единица измерения данных:

- в двоичной системе счисления единица измерения - бит (bit - binary digit - двоичный разряд);

- в десятичной системе счисления единица измерения - дит (десятичный разряд).

Рис. 2.1. Меры информации

Количество информации I на синтаксическом уровне невозможно определить без рассмотрения понятия неопределенности состояния системы (энтропии системы). Действительно, получение информации о какой-либо системе всегда связано с изменением степени неосведомленности получателя о состоянии этой системы. Рассмотрим это понятие.

Пусть до получения информации потребитель имеет некоторые предварительные (априорные) сведения о системе a. Мерой его неосведомленности о системе является функция H(a), которая в то же время служит и мерой неопределенности состояния системы.

После получения некоторого сообщения b получатель приобрел некоторую дополнительную информацию I b (a), уменьшившую его априорную неосведомленность так, что апостериорная (после получения сообщения b) неопределенность состояния системы стала H b (a).

Тогда количество информации I b (a) о системе, полученной в сообщении b, определится как

I b (a) = H(a)-H b (a),

т.е. количество информации измеряется изменением (уменьшением) неопределенности состояния системы.

Если конечная неопределенность системы H b (a) обратится в нуль, то первоначальное неполное знание заменится полным знанием и количество информации I b (a) = H(a). Иными словами, энтропия системы H(a) может рассматриваться как мера недостающей информации.

Энтропия системы H(a), имеющая N возможных состояний, согласно формуле Шеннона, равна

![]() ,

,

где P i - вероятность того, что система находится в i-м состоянии.

Для случая, когда все состояния системы равновероятны, т.е. их вероятности равны P i = , ее энтропия определяется соотношением

![]() .

.

Часто информация кодируется числовыми кодами в той или иной системе счисления, особенно это актуально при представлении информации в компьютере. Естественно, что одно и то же количество разрядов в разных системах счисления может передать разное число состояний отображаемого объекта, что можно представить в виде соотношения

где N - число всевозможных отображаемых состояний;

m - основание системы счисления (разнообразие символов, применяемых в алфавите);

n - число разрядов (символов) в сообщении.

Наиболее часто используются двоичные и десятичные логарифмы. Единицами измерения в этих случаях будут соответственно бит и дит.

Коэффициент (степень) информативности (лаконичность) сообщения определяется отношением количества информации к объему данных, т.е.

Y=1/V д, причем 0 С увеличением Y уменьшаются объемы работы по преобразованию информации (данных в системе). Поэтому стремятся к повышению информативности, для чего разрабатываются специальные методы оптимального кодирования информации. Для измерения смыслового содержания информации, т.е. ее количества на семантическом уровне, наибольшее признание получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для этого используется понятие тезаурус

пользователя. Тезаурус

- это совокупность сведений, которыми располагает пользователь или система. В зависимости от соотношений между смысловым содержанием информации S и тезаурусом пользователя S p изменяется количество семантической информации I c , воспринимаемой пользователем и включаемой им в дальнейшем в свой тезаурус. Характер такой зависимости показан на рис. 2.2. Рассмотрим два предельных случая, когда количество семантической информации I c Максимальное количество семантической информации I c потребитель приобретает при согласовании ее смыслового содержания S со своим тезаурусом S p (S p = S p opt), когда поступающая информация понятна пользователю и несет ему ранее не известные (отсутствующие в его тезаурусе) сведения. Следовательно, количество семантической информации в сообщении, количество новых знаний, получаемых пользователем, является величиной относительной. Одно и то же сообщение может иметь смысловое содержание для компетентного пользователя и быть бессмысленным (семантический шум) для пользователя некомпетентного. При оценке семантического (содержательного) аспекта информации необходимо стремиться к согласованию величин S и S p . Относительной мерой количества семантической информации может служить коэффициент содержательности C, который определяется как отношение количества семантической информации к ее объему: Синтаксическая мера информации

В качестве синтаксической меры количество информации представляет объем данных. Объем данных V d

в сообщении «в» измеряется количестве символов (разрядов) в этом сообщении. Как мы упоминали, в двоичной системе счисления единица измерения - бит. На практике наряду с этой «самой мелкой» единицей измерения данных чаще применяется более крупная единица - байт, равная 8 бит

. Для удобства в качестве измерителей используются кило- (10 3), мега- (10 6), гига- (10 9) и тера- (10 12) байты и т.д. В знакомых всем байтах измеряется объем кратких письменных сообщений, толстых книг, музыкальных произведений, изображений, а также программных продуктов. Понятно, что эта мера никак не может характеризовать того, что и зачем несут эти единицы информации. Измерять в килобайтах роман Л.Н. Толстого «Война и мир» полезно, например, чтобы понять, сможет ли он разместиться на свободном месте твердого диска. Это столь же полезно, как измерять размер книги - ее высоту, толщину и ширину, чтобы оценить, поместится ли она на книжной полке, или взвешивать ее на предмет того, выдержит ли портфель совокупную тяжесть Итак. одной синтаксической меры информации явно недостаточно для характеристики сообщения: в нашем примере с погодой в последнем случае сообщение приятеля содержало ненулевой объем данных, но в нем не было нужной нам информации. Заключение о полезности информации следует из рассмотрения содержания сообщения. Для измерения смыслового содержания информации, т.е. ее количества на семантическом уровне, введем понятие «тезаурус получателя информации». Тезаурус - это совокупность сведений и связей между ними, которыми располагает получатель информации.

Можно сказать, что тезаурус - это накопленные знания получателя. В очень простом случае, когда получателем является техническое устройство - персональный компьютер, тезаурус формируется «вооружением» компьютера - заложенными в него программами и устройствами, позволяющими принимать, обрабатывать и представлять текстовые сообщения на разных языках, использующих разные алфавиты, шрифты, а также аудио- и видеоинформацию из локальной или всемирной сети. Если компьютер не снабжен сетевой картой, нельзя ожидать получения на него сообщений от других пользователей сети ни в каком виде. Отсутствие драйверов с русскими шрифтами не позволит работать с сообщениями на русском языке и т.д. Если получателем является человек, его тезаурус - это тоже своеобразное интеллектуальное вооружение человека, арсенал его знаний. Он также образует своеобразный фильтр для поступающих сообщений. Поступившее сообщение обрабатывается с использованием имеющихся знаний с целью получения информации. Если тезаурус очень богат, то арсенал знаний глубок и многообразен, он позволит извлекать информацию из практически любого сообщения. Маленький тезаурус, содержащий скудный багаж знаний, может стать препятствием для понимания сообщений, требующих лучшей подготовки. Заметим, однако, что одного понимания сообщения для влияния на принятие решения мало - надо, чтобы в нем содержалась нужная для этого информация, которой нет в нашем тезаурусе и которую мы в него хотим включить. В случае с погодой в нашем тезаурусе не было последней, «актуальной» информации о погоде в районе университета. Если полученное сообщение изменяет наш тезаурус, может измениться и выбор решения. Такое изменение тезауруса и служит семантической мерой количества информации своеобразной мерой полезности полученного сообщения. Формально количество семантической информации I s ,

включаемой в дальнейшем в тезаурус, определяется соотношением тезауруса получателя S i

, и содержания передаваемой в сообщении «в» информации S.

Графический вид этой зависимости показан на рис.1. Рассмотрим случаи, когда количество семантической информации I s

равно или близко к нулю: При S i

= 0 получатель не воспринимает поступающую информацию; При 0 < S i

< S 0 получатель воспринимает, но не понимает поступившую в сообщении информацию; При S i

-» ∞получатель имеет исчерпывающие знания и поступающая информация не может пополнить его тезауруса. Рис. Зависимость количества семантической информации от тезаурса получателя

При тезаурусе S i

> S 0

количество семантической информации I s

, получаемое из вложенной сообщение β

информации S

вначале быстро растет

с ростом собственного тезауруса получателя, а затем - начиная с некоторого значения S i - падает

. Падение количества полезной для получателя информации происходит оттого, что багаж знаний получателя стал достаточно солидным и удивить его чем-то новым становится все труднее. Это можно проиллюстрировать на примере студентов, изучающих экономическую информатику и читающих материалы сайтов по корпоративным ИС.

Вначале при формировании первых знаний об информационных системах чтение мало что дает - много непонятных терминов, аббревиатур, даже заголовки не все понятны. Настойчивость в чтении книг, посещение лекций и семинаров, общение с профессионалами помогают пополнить тезаурус. Со временем чтение материалов сайта становится приятным и полезным, а к концу профессиональной карьеры - после написания многих статей и книг - получение новых полезных сведений с популярного сайта будет случаться намного реже. Можно говорить об оптимальном для данной информации S

тезаурусе получателя, при котором им будет получена максимальная информация Is, а также об оптимальной информации в сообщении «в» для данного тезауруса Sj.

В нашем примере, когда получателем является компьютер, оптимальный тезаурус означает, что его аппаратная часть и установленное программное обеспечение воспринимают и правильно интерпретируют для пользователя все содержащиеся в сообщении «в» символы, передающие смысл информации S.

Если в сообщении есть знаки, которые не соответствуют содержимому тезауруса, часть информации будет утрачена и величина I s

уменьшится. С другой стороны, если мы знаем, что получатель не имеет возможности получать тексты на русском (его компьютер не имеет нужных драйверов), а иностранных языков, на которых наше сообщение может быть послано, ни он, ни мы не изучали, для передачи необходимой информации мы можем прибегнуть к транслитерации - написанию русских текстов с использованием букв иностранного алфавита, хорошо воспринимаемого компьютером получателя. Так мы приведем в соответствие нашу информацию с имеющимся в распоряжении получателя тезаурусом компьютера. Сообщение будет выглядеть некрасиво, но всю необходимую информацию получателю удастся прочитать. Таким образом, максимальное количество семантической информации Is из сообщения β

получатель приобретает при согласовании ее смыслового содержания S c

тезаурусом Si,

(при Si

= Sj opt).

Информация из одного и того же сообщения может иметь смысловое содержание для компетентного пользователя и быть бессмысленной для пользователя некомпетентного. Количество семантической информации в сообщении, получаемом пользователем, является величиной индивидуальной, персонифицированной - в отличие от синтаксической информации. Однако измеряется семантическая информация так же, как синтаксическая, - в битах и байтах. Относительной мерой количества семантической информации служит коэффициент содержательности С, который определяется как отношение количества семантической информации к ее объему данных V d ,

содержащихся в сообщении β:

С = Is / Vd

Лекция 2 по дисциплине «Информатика и ИКТ»

Рис. 2.2. Зависимость количества семантической информации, воспринимаемой потребителем

равно 0: